Las caídas de tráfico en una web no suelen ser algo que ocurra todos los días, y obviamente encontrarte con una caída muy abrupta puede ocasionar al webmaster un pre-infarto, más si una persona o una empresa vive de ese proyecto. Por desgracia este tipo de casos nos pueden afectar a todos.

En este artículo podrás encontrar las razones de los principales errores por lo que puedes tener una caída de tráfico y cómo evitarlos o solucionarlos.

Evaluar el porcentaje de caída

Tabla de contenidos

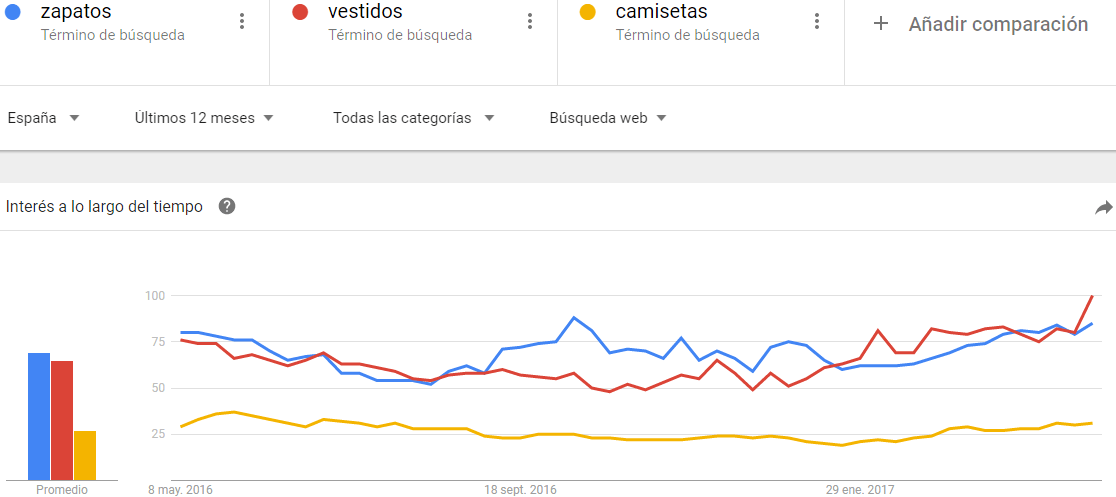

ToggleAntes de nada debemos de evaluar qué porcentaje de bajada ha tenido el proyecto. Porque no es lo mismo una bajada de un 10% a un 70% o más. Ni tampoco es lo mismo una caída de tráfico muy destacada de un día para otro, que ir perdiendo tráfico poco a poco. Dependiendo del proyecto y la temática, puede tener una estacionalidad. No es lo mismo un proyecto de turismo que uno de moda, ya que el de moda suele tener una estacionalidad constante y en cambio el de turismo tendrá picos de subidas en los meses de antes a los festivos o vacaciones. Y por ejemplo, dentro de la moda, no actúa igual un proyecto de zapatos que otro de bañadores, que si podría sufrir de la estacionalidad anterior.

Ejemplo de tendencia de búsqueda en Hoteles en España en los últimos 5 años:

Ejemplo de tendencia de búsqueda en Hoteles en España en el 2016:

Ejemplos de tendencia de búsqueda en Hoteles en España en el sector de moda:

Por eso debemos de tratar cada proyecto de forma distinta.

Disponer de Analytics bien instalado

No es raro que tras una migración de plataformas (por ejemplo, de Woocommerce a Prestashop), se pueda desconfigurar el código de Google Analytics del sitio web. En ese caso, podemos encontrarnos con bajadas de tráfico de 75% o incluso mayores.

Por ejemplo, un proyecto tenía tráfico y de repente ha perdido visibilidad en Google. Como hay tráfico, en principio se descarta que sea el problema del código de Analytics, pero en realidad el problema puede residir en que el Prestashop si tenía el código pero el Blog no, y el 75% del tráfico venía del Blog. La forma de solucionarlo obviamente es volver a configurarlo en el Blog, y tras la migración realizar las redirecciones correspondientes para recuperar visibilidad. Pero lo que parecía un problema de estrategia o penalización, era simplemente un error de lectura.

¿Qué fuente de tráfico ha bajado?

Tal y como hemos comentado en el paso anterior, disponiendo de un acceso a Analytics bien configurado, podremos evaluar bien cuales son los datos y a que tráfico no referimos. Un usuario que no tiene mucho conocimiento de esta herramienta suele ver solamente el tráfico general y no ve el desglose de cada una de las fuentes. Por eso antes de pensar que es tráfico orgánico hay que mirar todas las fuentes y ver cual es la que ha sufrido la caída. Porque puede ser tráfico Directo, de RRSS, Orgánico, o incluso tráfico desde una campaña de Email Marketing.

La web está online?

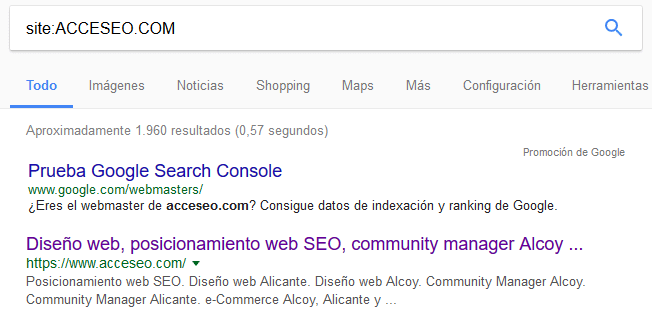

Lo más rápido y fácil es buscar el dominio con el comando Site de Google, ejemplo site:dominio.com. Google nos dará el resultado de casi todas las páginas indexadas, no tiene porque aparecer exactamente todas las páginas, ya que tras nuestra experiencia hemos visto casos en los que ha pasado esa situación. Por ejemplo, si se eliminan todas las URL de un idioma en concreto de una tienda online, en el «site» ya no aparecen esas páginas, pero en búsquedas manuales se puede observar como si existe una indexación.

hay que tener en cuenta que si no devuelve ningún resultado es que se ha desindexado por completo el dominio, pero no suele ser el caso, salvo una penalización manual. Lo más normal es que haya muchas menos páginas indexadas de las que tiene el sitio.

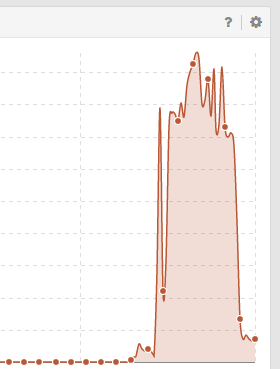

Si este es tu caso te recomiendo que mires en las herramientas Sistrix o Semrush si ha habido una bajada de visibilidad y si esa bajada coincide con algún cambio que hayas hecho en la web.

En este ejemplo se muestra una subida y bajada muy grande en un período de tiempo muy corto. En este caso, el proyecto al que pertenece esta gráfica tenía una sobre-optimización que hizo que tan rápido como subió, volviera a bajar posiciones.

El Robots.txt

Si ha habido una caída muy muy grave de visitas o posiciones, hay que revisar de inmediato el archivo robots.txt. A veces cuando se realiza un cambio, por ejemplo en WordPress, o se instala algún plugin, puede que modifique este fichero. Revisarlo nos tomará 5 minutos y es una práctica muy recomendable. Se puede revisar desde la ruta dominio.com/robots.txt.

Mostramos un ejemplo de cómo sería un Robots.txt con un problema de desindexación:

User-agent: *

Disallow: /

Disallow: /wp-admin/

Si aparece la línea “Disallow: /” es que existe un problema. Esa línea le indica a los buscadores que no indexe ningún resultado de la web. Se soluciona eliminando la línea.

En caso de que se tenga por ejemplo otra línea como “Disallow: /es/” y justamente es la ruta la cual ha bajado (lo puedes ver en Sistrix); la solución es la misma. Se elimina la línea y listo, Google debería de volver a indexar todas las url nuevamente.

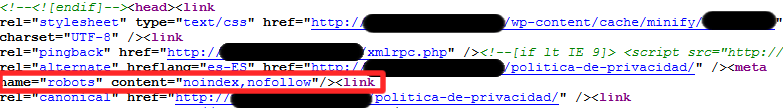

Etiqueta rel=”NoIndex”

Este es otro caso muy típico de páginas web con bajadas grandes de visibilidad. Es una etiqueta que le indica a los buscadores que no indexe esa página. Muchas gente los suele usar para las páginas de Política de Privacidad, Condiciones, Envíos, Cookies, etc…

No es raro que se trabaje una web en «local» y luego subirlo al servidor, acabar de rematar detalles y no quitar el noIndex (se suele activar para que no haya contenido duplicado en caso de trabajar en productivo una web paralela). En algunos casos, lo curioso es que solamente la Home tiene esa etiqueta pero las otras URL no, pero la mayoría de las palabras claves posicionaban en la Home.

Si se elimina esa etiqueta a tiempo, normalmente Google lo vuelva a indexar en un par de horas o menos.

Este es un ejemplo de la etiqueta:

¿Cómo revisar el rel=NoIndex en cada url?

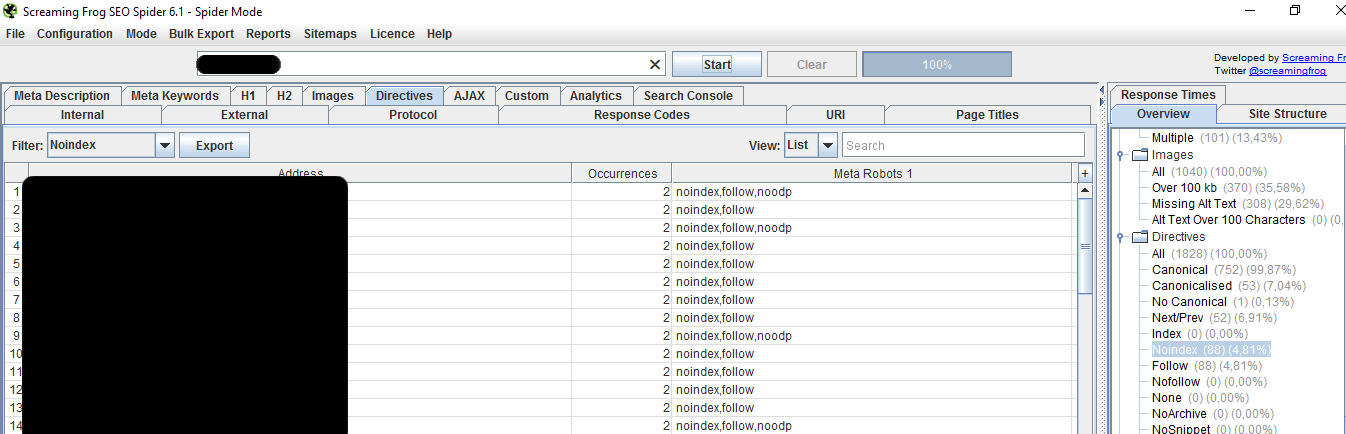

Tardaríamos horas si tenemos 2000 páginas. Por eso lo que debemos hacer es pasar la web por programas como Screaming Frog, que analizan el estado de todas las URLs de un sitio web y te permite exportar dichas URLs

Como se muestra en la imagen, hay que escanear el sitio completo. Luego en el menú de la derecha, en Directives, buscamos la opción “Noindex” y ahí nos aparecerá la cantidad de URL que tienen esta etiqueta.

Con este programa también podemos ver si hay otros problema como por ejemplo los Canonical, o redirecciones, o errores 404 que también afectan al SEO y a la visibilidad.

Revisar Search Console

Otro lugar para revisar si hay algún problema es el Search Console, en antiguo WebMaster Tools. Podemos ver si hay una bajada del estado de indexación, recursos bloqueados, etc.. En la sección de Analítica de Búsqueda podemos ver si las búsquedas han bajado y los clicks que recibimos. Una forma fácil de verlo es ver si el CTR ha bajado. Si las búsquedas se mantienen y el Click y el CTR ha bajado es porque se ha perdido la visibilidad en Google.

Una sección muy importante que debemos mirar es la de Acciones Manuales, ya que aquí nos llegarán un mensaje en caso de haber sufrido una penalización.

Si al revisar todo lo anterior no encontramos el problema seguramente sea por alguna penalización manual o automática debido a una sobre optimización, backlinks, contenido duplicado, etc.. En ese caso se tendrá que analizar dónde podría estar el problema de forma más profunda.